基于shuffle-attention的语音情感识别研究

本文模型是在基于area-attention的模型上改进得到的

本文模型在github的源码仓库为:https://github.com/V1per3/shuffle_attention_for_SER

如下图所示:

本文模型将Shuffle Attention与卷积神经网络结合构建了一个新型的语音情感识别模型,该模型通过librosa音频处理库将原始音频文件处理成梅尔频谱图(logMel spectrogram)作为学习的特征,将其送入到两个并行卷积层,分别从时间轴和频率轴提取纹理;结果被送入到五个连续的卷积层,并生成一个128通道的张量。对于这5个连续的卷积层(CNN Block),本文采用残差连接的思想对传统卷积神经网络进行优化改进而得到,之后再将卷积神经网络输出的结果送入到Shuffle Attention注意力层中,捕获频谱图中成对的像素级关系和通道间依赖关系,从通道和空间两个方面来提取特征,最后再送入到全连接层中进行分类。在第一个和第二个CNN Block之后通过Max Pooling进行降采样。

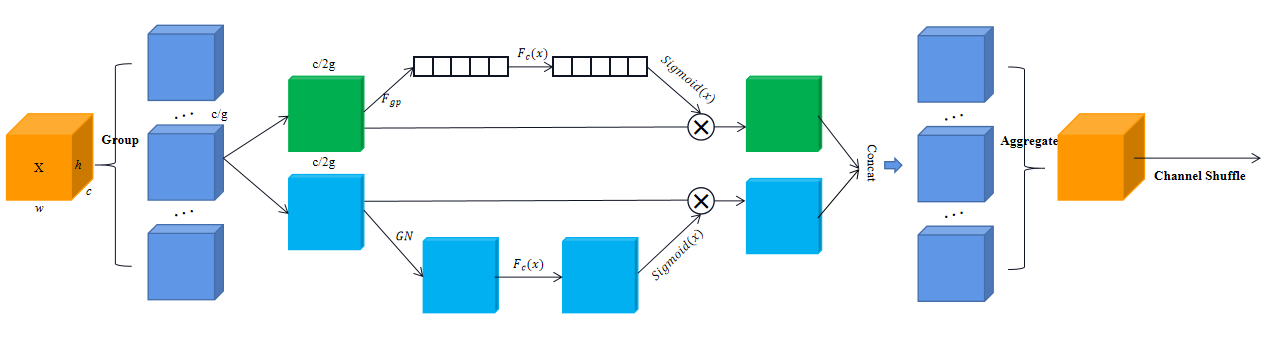

shuffle attention的具体机理如下图所示:

首先将输入的特征沿着通道方向分为g组,然后对每一组的特征进行分割(split)操作,对分割后的两个分支分别使用全局平均池化和组归一化来提取通道注意力和空间注意力,之后分别使用一对参数对张量进行缩放和平移,随后对两种注意力都使用sigmoid进行计算得到对应的权值矩阵,再分别与原始输入特征相乘进而得到想要的特征。接着,将两个分支的结果拼接到一起,然后合并,得到和输入尺寸一致的特征图。最后,用一个Channel Shuffle函数进行处理,融合不同组之间的信息。

对于语言情感识别任务,引入Shuffle Attention,具有以下意义:首先,Shuffle Attention机制能够捕捉语音信号中频谱图像素级的局部关系。情感信息常常体现在语音信号的细微变化和局部区域中,通过对频谱图的局部关系进行建模,Shuffle Attention可以有效地提取关键的情感相关特征。第二,Shuffle Attention结合卷积神经网络,能够从通道和空间两个方面提取特征。通过对频谱图中的通道和空间信息进行交叉注意,模型可以更全面地理解语音信号中的情感表达,并提高特征的表达能力。第三,通过捕捉局部关系、增强特征学习和优化特征表达能力,Shuffle Attention可以提高模型对情感信息的敏感性和识别准确度,从而提升语音情感识别模型的性能。

现有的语音情感识别模型大多从空间注意力或者通道注意力某一粒度出发,不能充分提取频谱图中的信息,而本文模型从通道和空间两个方面来提取特征,并且引入残差连接来加深网络深度,增强网络对于语言情感的预测精确度,加权精度(WA)与非加权精度(UA)分别达到了82.21%、80.09%,相较于基准模型提高了约2.87%、2.55%,获得了十分具有竞争力的结果。